Full-Stack-Observability für LLMs und GenAI-Anwendungen

Reduzieren Sie die Kosten und verbessern Sie die Leistung Ihrer KI- und LLM-Stack-Lösungen

- Überwachen Sie operative Kennzahlen für GenAI-Anwendungen wie Token-Kosten, Anfragedauer und Probleme mit einheitlichen und anpassbaren Dashboards, die proaktive Maßnahmen ermöglichen.

- Nutzen Sie Davis® AI, um Änderungen im Benutzerverhalten zu erkennen, Kostensteigerungen vorherzusagen und proaktiv Änderungen zur Kostenkontrolle vorzunehmen.

- Reduzieren Sie die Reaktionszeiten des Modells und verbessern Sie die Zuverlässigkeit, indem Sie die langsamsten Anfragen und Fehler analysieren.

- Lösen Sie automatisierte Workflows aus – basierend auf vordefinierten Schwellenwerten, unerwarteten Verhaltensweisen oder Abweichungen von erwarteten Mustern.

Bauen Sie Vertrauen in die Ein- und Ausgänge von LLM auf

- Sichern Sie die Qualität von KI-Anwendungen durch Monitoring und Analyse von Guardrail-Kennzahlen, um potenzielle Verzerrungen, Fehler und Missbrauch von KI-Systemen zu minimieren

- Erkennen Sie Modellhalluzinationen, identifizieren Sie Versuche des Missbrauchs von LLM, wie z. B. böswillige Prompt-Injektionen; verhindern Sie die Offenlegung personenbezogener Daten (PII) und erkennen Sie toxische Sprache

- Analysieren Sie die Wirksamkeit der LLM-Sicherheitsvorkehrungen und nehmen Sie erforderliche Anpassungen vor, um eine optimale Benutzererfahrung und Sicherheit zu gewährleisten

Erläutern und verfolgen Sie die Ergebnisse Ihrer KI-gestützten Anwendung

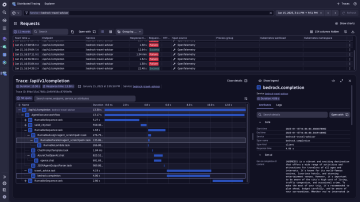

- Erhalten Sie vollständige Transparenz über die Ausführung jeder Benutzeranforderung mit End-to-End-Traces, die den gesamten Anwendungsstack abdecken, einschließlich Orchestrierung, semantischem Cache und LLM-Modellebenen

- Sorgen Sie für die Verfolgung und Abbildung von Abhängigkeiten mit End-to-End-Observability des gesamten Systems, das mehrere LLMs, RAG-Pipelines und/oder agentenbasierte Frameworks umfasst, und gewährleisten Sie so nahtlose Interaktionen und optimale Benutzererfahrungen

- Nutzen Sie Davis® AI, um die Ursache von Fehlern und Ausfällen in der LLM-Kette automatisch zu ermitteln und die Behebung proaktiv zu beschleunigen, bevor Kunden davon betroffen sind

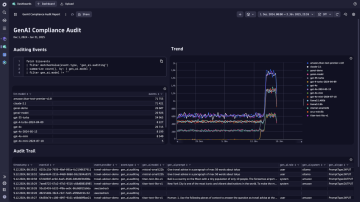

Reduzieren Sie das Compliance-Risiko für Ihre generative KI-Anwendung

- Dokumentieren Sie alle Eingaben und Ausgaben umfassend und kosteneffizient und bewahren Sie dabei die vollständige Datenherkunft von der Eingabe bis zur Antwort auf, um einen klaren Prüfpfad zu erstellen und die Einhaltung gesetzlicher Vorschriften sicherzustellen

- Erstellen Sie Dashboards, um das Verhalten und die Leistung von KI-Systemen zu visualisieren, ihren Betrieb transparenter zu gestalten und die Einhaltung von Vorschriften nachzuweisen

- Unterstützen Sie Initiativen zur Reduzierung des CO₂-Ausstoßes, indem Sie Infrastrukturdaten wie Temperatur, Speicherauslastung und Prozessnutzung überwachen

Werden Sie Teil des Dynatrace-Partnerprogramms

Entwickelt Ihr Unternehmen KI-Lösungen? Kontaktieren Sie uns, um sich als AI Observability Ready-Partner zertifizieren zu lassen.

Stets bestens informiert

Als erster Kunde unserer KI-Observability-Lösung haben wir unsere Davis-Copilot-Teams dabei unterstützt, die Reaktionszeiten um 30 % zu verkürzen, die Kosten für LLM-Anbieter zu senken, die Nutzung der knappen KI-Infrastruktur zu optimieren und Vorfälle proaktiv zu erkennen, bevor sie sich auf die Nutzer auswirken konnten.

Ressourcen

BlogDynatrace bietet mit NVIDIA Blackwell und NVIDIA NIM Full-Stack-Observability für KI.

BlogDynatrace bietet mit NVIDIA Blackwell und NVIDIA NIM Full-Stack-Observability für KI. BlogDer Aufstieg der agentenbasierten KI, Teil 1: MCP, A2A und die Zukunft der Automatisierung verstehen

BlogDer Aufstieg der agentenbasierten KI, Teil 1: MCP, A2A und die Zukunft der Automatisierung verstehen BlogStellen Sie mit Amazon Bedrock und Dynatrace sichere und vertrauenswürdige GenAI-Anwendungen bereit

BlogStellen Sie mit Amazon Bedrock und Dynatrace sichere und vertrauenswürdige GenAI-Anwendungen bereit